GDD 2011 Japanの会場の様子

Google Developer Day 2011 Japanに行ってきたので会場の様子をちょっと紹介。

基調講演やブレイクアウトセッションについては前のエントリで少し書いたのでそちらをどうぞ。

エントランスロビー。オブジェは正二十面体にGDDの開催地がマッピングされた展開図になってるらしいです。

デベロッパーサンドボックスのコーナー。芝浦工業大学とco-meeting

NFCを使ったスタンプラリー的なもので、「NFC QUEST」。会場内のいろんなところにNFCのチェックポイントがあって、入場時に配布されたカードでタッチするようになってました。右下の写真はBar Androidの出張店舗。

こちらはGTUGコーナー。

Chrome Bookも展示されていました。ちょっとしか触ってないですが、普通のノートPCとすごく違うような印象は受けませんでしたね。

さらにGoogle TVも。今度docomoから出るGalaxyも展示されてたらしいのですが、私は見てきませんでした。

こちらはAndroid関連の展示。

パノラマなGoogle Earth。

メディアラボとGooglerによるパフォーマンス。メディアラボはGoogleとのコラボでWebサイトへアクセスすることによる観客参加型のセッション。Node.jsとWeb Audio APIを使った仕組みだそうです。Googlerは須藤元気のWORLD ORDERと同じダンスパフォーマンス。ダンス経験者はほとんどいなかったそうですがそうとは思えないなかなかすごいものでした。

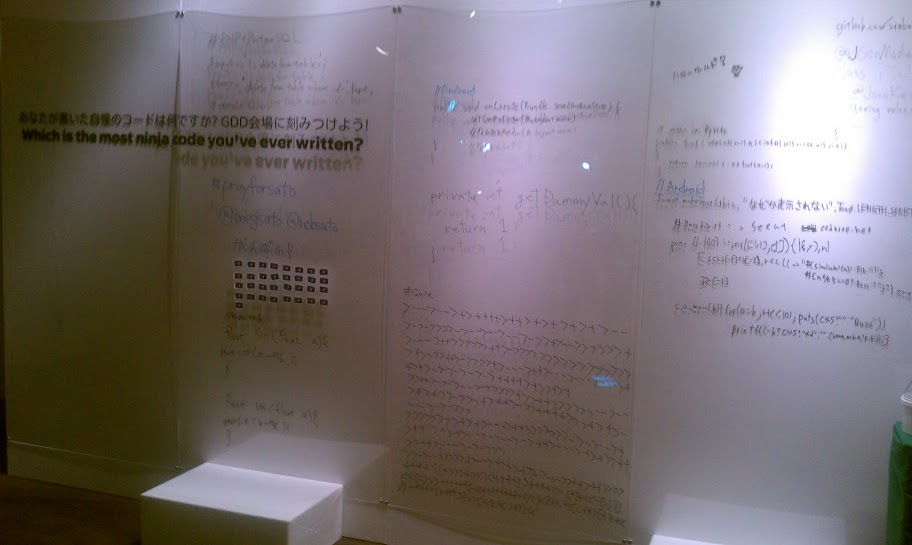

「あなたが書いた自慢のコードは何ですか?GDD会場に刻みつけよう!」ということで参加者が自由にコードを書き込めるボード。右は終了後に会場外で取った夜景です。

GDD Tシャツ。洗うとすごく色落ちしますw 缶バッジは入場時に一人当たり同じものが10個ずつ配られて、他の参加者と交換してコンプリートしてくださいということでした。参加者間の交流を促すための取り組みですね。私は知らない人に話しかけるのが苦手なので集まったのはこれだけw

こちらも全員に配布されたzeemoteのBluetooth接続のジョイスティック。Android端末でゲームをやるときに使えます。ゲーム以外にもBluez IMEというIMEアプリを入れるとキーボード入力代わりにつかえるので、プレゼンでスライド送ったりとかにも使えていい感じです。3Dメガネはクロージングで動画を見るのに使う予定だったらしいのですが、Igniteが長引いたことで割愛されてしまったそうで。。。出番ありませんでした。

全体的な感想としては、入場時の配布物とか昼のお弁当配布とかはもうちょっとスムーズにならないかなぁという感じです。だいぶ並んで待っている時間が長かったので。。

セッションをしっかり聞こうと思うとバッジの交換とかブースを回ったりとかっていう時間はあんまり取れないのが残念なところですね。

あとはセッション会場でも電源が取れると良かったんですが。。